Парсинг ключевых слов

Содержание:

- Парсинг поисковых подсказок

- Как пользоваться парсером Wordstat от Click.ru

- Как узнать возможности чипсета?

- Пиксель Тулс

- 8 лайфхаков для ресторанного SMM

- Как поменять валюту в «Стиме» на доллары?

- Как правильно парсить в Вордстат: обзор программ для анализа поисковой выдачи

- Метод для получения максимального охвата

- PromoPult

- Ключевые идеи статьи

- Оффлайн парсеры

- Зачем нужен Kparser?

- Программы парсеры

- UDPipe 2.0

- Версии навигатора и системные требования для Андроид

- Способ 2. Собираем запросы «с хвостами» на площадках вопросов и ответов

- Кому нужен онлайн комбинатор?

- Сколько ключевых слов должно быть в семантике

- Перечень функций:

- Советы и рекомендации по использованию программ для парсинга

- Плюсы и минусы работы с Кей Коллектором

- Программы и сервисы для парсинга

- Общие выводы

Парсинг поисковых подсказок

Поисковые подсказки — хороший источник «живой» семантики. Чтобы не собирать ее руками, используйте шаблон от Ranktank.

Что нужно для начала работы:

- создайте фейковый аккаунт в Google (при запуске скрипта в шаблоне Google «ругается» из-за непроверенного источника — не стоит лишний раз разбрасываться личными данными);

- войдите в этот аккаунт и создайте копию шаблона Keyword Research Tool with Google Autocomplete API 2.0.

Как собрать подсказки:

- переходим на лист «KW Research» и выбираем в поле «Keyword» слово, по которому будем собирать подсказки, а также указываем язык;

- в верхней таблице в левом столбце собраны подсказки по основному запросу, а в остальных столбцах — подсказки по только что собранным подсказкам;

- нажимаем на «+» (для работы скрипта потребуется подтверждение доступа к Google-аккаунту);

- после этого собранные ключи перенесутся в столбец «Keywords»;

Полезные фишки шаблона:

Несмотря на все преимущества шаблона у него есть недостаток — парсинг только в том регионе, из которого зафиксирован вход в Google-аккаунт. Для информационных запросов это не критично, но для коммерческих (зачастую геозависимых) — проблема.

Поэтому для подбора подсказок по геозависимым фразам лучше использовать продвинутые парсеры — например, парсер PromoPult. Здесь можно указать любой регион России и мира, задать глубину и правила парсинга, настроить источники парсинга (не только Google, но и Яндекс, и YouTube).

Вот гайд по парсингу подсказок для SEO.

Как пользоваться парсером Wordstat от Click.ru

В числе инструментов Click.ru как раз есть функциональный и недорогой парсер Wordstat. Он быстро выдает частотность даже по большому списку запросов. При этом учитывает типы соответствия и региональность. Еще не требует капчу и прокси-серверы, а отчеты позволяет выгружать в Excel и хранить в «облаке».

Для начала работы зарегистрируйтесь в системе Click.ru. После входа в свой аккаунт на главной странице выберите раздел «Парсер частоты Wordstat» и приступайте к работе.

Для начала парсинга перейдите в соответствующий раздел

Как работать с парсером Wordstat после регистрации в Click.ru:

Загрузите список запросов.

Есть два способа: скопировать и вставить ключи в специальное поле или же загрузить XLSX-файл с ними.

При копировании списка учитывайте, что каждый ключ должен идти с новой строки. А в эксель-файле смотрите, чтобы не было вспомогательной информации (названий столбцов, лишних цифр и т. д.). Система берет запросы из первого листа .XLSX по принципу «одна ячейка – один ключ».

Этап загрузки запросов

Выберите регионы.

В системе доступны все регионы Яндекса. Можно посчитать общую частотность по нескольким регионам или получить статистику отдельно по каждому.

Разделять регионы в отчете нужно, если вы планируете продвигать бизнес отдельными региональными поддоменами и посадочными страницами, привязанными к географии. В остальных случаях галочка не ставится.

Выбираем регионы

Укажите тип соответствия.

Широкое соответствие – когда фразы пробиваются как есть – часто показывает обманчивую частотность. Все из-за того, что учитываются все вложенные ключи, в том числе нерелевантные (как в примере с игрушками). То есть всегда лучше перепроверять частоту запроса с помощью специальных операторов.

Кавычки позволяют уточнять статистику по конкретной фразе, без учета вложенных ключей.

Пример

| скачать видео бесплатно – 1 111 285 показов | “скачать видео бесплатно” – 8 493 показа |

Кавычки с восклицательными знаками показывают частотность по заданным словоформам.

Пример

| “!купить !телефон” – 37 909 показов | “!купить !телефоны” – 2 798 показов |

Квадратные скобки – фиксируют порядок слов, что особенно важно в туристическом бизнесе

Пример

| – 4 213 показов | – 1 814 показов |

Все варианты типов соответствия

Запустите проверку.

Время сбора частотностей зависит от количества запросов, регионов и типов соответствия. Если запросов меньше 1 000, процесс займет 1–2 минуты.

Результат будет доступен в списке задач. Можно открыть отчет в браузере или скачать его в формате XLSX.

Здесь будут появляться отчеты со статистикой

Как узнать возможности чипсета?

Данные о спецификации тех или иных чипсетов можно посмотреть на официальных сайтах AMD или Intel. К примеру, чтобы получить информацию о чипсете HM76 (Intel) необходимо:

Шаг 1. Перейти в Google, ввести в поисковой строке «Intel HM76».

Переходим в Google, вводим в поисковой строке «Intel HM76»

Шаг 2. Перейти по первой ссылке, ведущей на сайт ark.intel.com. Там и будут указаны все спецификации необходимого чипсета.

Переходим по первой ссылке, ведущей на сайт ark.intel, читаем информацию о чипсете

Итого, узнать марку установленного чипсета можно и без разборки ПК или ноутбука.

Пиксель Тулс

Не совсем стандартный парсер, который ориентируется, в числе прочего, на поисковые подсказки. Присутствует функция перебора, которая позволяет повысить итоговую результативность работы парсера.

Производитель — знаменитая компания, давно специализирующая на создании специализированных инструментов для оптимизации и продвижения сайтов. Допускается устанавливать конкретный регион поиска для сбора и обработки информации.

Помимо платных сервисов существует обилие бесплатных услуг, с помощью которых можно провести анализ положения сайта и улучшить его характеристики.

Основные преимущества:

-

Разнообразие бесплатных услуг. Некоторые из этих услуг предоставляются другими компаниями за деньги.

-

Комплексный подход. В одном месте собрано множество инструментов для продвижения сайтов включая внешнюю и внутреннюю оптимизацию.

- Возможность посмотреть на одном экране множество показателей для более удобной аналитики.

Пиксель Тулс 7

8 лайфхаков для ресторанного SMM

Как поменять валюту в «Стиме» на доллары?

Как правильно парсить в Вордстат: обзор программ для анализа поисковой выдачи

Парсинг выдачи Яндекса – это процесс сбора поисковых запросов по заданной тематике (с помощью базовых маркеров). С Yandex Wordstat Assistant можно легко получить основную информацию для формирования семантического ядра – поисковые запросы, количество показов в месяц по каждой фразе, а также схожие по тематике слова, помогающие расширить охват целевой аудитории. Парсер Wordstat позволяет получить информацию по словам и по регионам, при этом система ориентируется именно на сайты.

Если хотите выполнить расширенный поиск, включающий не только Яндекс, но и социальные сети и другие поисковые системы, необходимо воспользоваться универсальными инструментами, например, A-Parser. Этот программный продукт отличается удобством в работе, но для эффективной работы с ним нужно купить прокси для парсинга.

В какой среде бы Вы ни работали, используйте универсальную схему сбора семантического ядра:

- формирование базового списка маркеров (запросов, однозначно релевантных сайту);

- сбор ключевых слов;

- удаление «мусора» — ненужных и случайно попавших в список запросов;

- кластеризация ключевиков по разделам сайта или тематикам.

Рассматриваем основной алгоритм работы с Вордстат и парсим Яндекс для сбора семантики на примере сайта агентства недвижимости. Допустим, нам нужно составить перечень релевантных ключевых запросов, соответствующих базовому маркеру «аренда квартир».

- Вводим базовый маркер в поисковую строку Яндекс Вордстат.

- При необходимости устанавливаем регион для более точного отбора запросов (например, Москва или Санкт-Петербург).

- В полученных результатах поиска используем значок «+» для выгрузки в таблицу Excel.

- Выгружаем полученные данные через буфер обмена (инструмент «A-Z»).

Совет! Обращайте внимание на подсказки типа «вместе с этим ищут» в соседнем поле выдачи результатов парсинга – это поможет вам охватить больше аудитории при составлении SEO-контента. Чтобы облегчить себе задачу по ручному парсингу, используйте операторы Яндекс

Например, поставив в конце поисковой фразы знак «!», вы зафиксируете окончание поискового запроса, и система будет искать слова именно в этой словоформе. Оператор «-» (минус) позволит убрать лишние слова, а квадратные скобки «» — зафиксировать порядок слов в запросе

Чтобы облегчить себе задачу по ручному парсингу, используйте операторы Яндекс. Например, поставив в конце поисковой фразы знак «!», вы зафиксируете окончание поискового запроса, и система будет искать слова именно в этой словоформе. Оператор «-» (минус) позволит убрать лишние слова, а квадратные скобки «» — зафиксировать порядок слов в запросе.

Метод для получения максимального охвата

Этап 1: соберите общие фразы, которые описывают ваш продукт

Ответьте на вопрос, как его называет ЦА. Придумайте все возможные формулировки, написания (в том числе русские для зарубежных брендов) и синонимы.

Можно взять их из описания сегментов целевой аудитории. В нашем примере — семантика для курсов английского языка, сегмент «Карьеристы».

Примерные запросы для этого типа ЦА:

- «Деловой английский курсы»;

- «Бизнес английский»;

- «Карьера в зарубежной фирме»;

- «Английский для работы»;

- «Деловой английский по скайпу»;

- «Курсы английского с сертификатом»;

- «Английский интенсивный курс».

Постройте таблицу в любом формате, чтобы фиксировать идеи. Занесите то, что есть на данный момент:

Это удобный формат отчета: всё сгруппировано по темам, брендам, категориям, проще оценивать общую частотность и в дальнейшем — размер низкочастотного хвоста.

Столбец «Семантика» — это количество уникальных фраз с ненулевой частотностью для этой маски. Его мы заполняем далее — на этапе парсинга СЯ. Сейчас только выписываем частотность из Яндекс Wordstat.

Столбец «Раздел» пригодится, если у вас много товаров, брендов, категорий.

Этап 2: пробейте фразы в Wordstat

Используйте только широкое соответствие, чтобы получить по максимуму вложенные запросы из каждого базиса.

Сервис выдает количество показов рекламных блоков Яндекса. Чем уже запрос, тем меньше предполагаемое количество запросов и трафика на сайт, а следовательно — охвата ЦА.

Не забудьте настроить регион, если у вас локальный бизнес.

Фразы с очень низкими показателями лучше заменить на более емкие, так как ваша задача — получить маски, которые потенциально дают большое количество расширений при дальнейшем парсинге.

При этом исключайте варианты с нулевой частотностью:

Можно их также уточнить, чтобы получить больший прогнозируемый охват

Но учитывайте, что при этом в выдаче могут появиться нецелевые запросы, например:

Желательно сразу вносить их в минус-файл либо исключить при поиске:

Важно! Оценивайте результаты выдачи сразу, чтобы в дальнейшем избежать лишней работы. Если в выборке много лишнего, не стоит брать этот базис.

Например, запрос «Английский для работы» дает не те результаты, которые нужны для СЯ

Мы подразумевали под работой карьеру, но не как школьное задание.

В нашем случае всё, что связано со школой — «контрольная работа», «домашняя работа», «по-английски», «рабочая тетрадь» и т.д. — это минус-слова.

Пробуем уточнить формулировку. Совсем другая ситуация по фразе «Английский для работы за рубежом», но выдача маленькая.

Принцип №1: для полноценного СЯ подбирайте такие маски, чтобы «зацепить» больше расширений (охвата) и меньше «мусора».

По мере парсинга масок в Wordstat заполняйте таблицу. У нас получаются такие данные:

Результаты довольно скромные, если пользоваться только выдачей Wordstat. За счет чего их можно расширить? Идем дальше.

Этап 3: посмотрите похожие запросы в Яндекс Wordstat

Принцип №2: используйте ключевые фразы в правом столбце как идеи, а не просто копируйте. Выделяйте из них полезные составляющие, расширяйте их как угодно, убирайте лишние слова.

Параллельно проверяйте каждую идею на содержание в поисковиках, чтобы представлять, какие запросы по нему вводят:

И отсеивайте то, что не попадает в тему.

Этап 4: изучите источники семантики

Принцип тот же — придумывайте маски из того, что увидите. Например, загляните в:

Поисковые подсказки Яндекс и Google:

Похожие запросы в SERP:

Статистику запросов Mail.ru

А также сервисы синонимов, форумы, Alt-теги к картинкам в поисковой выдаче, Планировщик ключевых слов Google и т.д.

Полезно черпать идеи с сайтов конкурентов.

Отдельно пара слов о сервисе SpyWords. Это не буквальное руководство. База запросов, по которой раз в месяц снимается поисковая выдача и реальные запросы — это разные вещи. Копировать их бессмысленно, а поискать идеи для новых масок стоит.

Рекомендация та же: проверяйте результаты в поисковой выдаче. Плюс пробивайте на частотность в Яндекс Wordstat.

Заносите в таблицу те, где частотность выше нуля. Вот некоторые маски, которые мы получили из похожих запросов и поисковых подсказок:

PromoPult

Еще один парсер, которым можно пользоваться онлайн. Бесплатно доступно 50 запросов чтобы пользователь мог познакомиться с инструментом, изучить его особенности. Для парсинга запросов можно использовать как файлы XLCX или вводить ключевые фразы вручную.

Можно выбирать конкретный регион для парсинга, а результаты проведенного исследования сохранять в облаке. Срок хранения неограничен. При необходимости, вы можете в любой момент обратиться к ранее созданному отчету и просмотреть его.

Полезная информация: сервис позволяет отказаться от необходимости вводить капчу или использовать прокси. Клиент просто запускает работу скрипта, а затем наслаждается полученным результатом. Уведомление об окончании работы приходит на указанный адрес электронной почты.

Цена различается от многих факторов среди которых общее количество запросов, использование дополнительных функций, очередность запросов. Конечная стоимость составляет от 2 до 12 копеек за съем одной позиции.

Основные преимущества:

-

Web-интерфейс и хранение информации в облаке с возможностью скачать файл XLCX. Неограниченный срок хранения данных по достоинству оценят оптимизаторы больших проектов.

-

Высокая скорость парсинга при гибкой ценовой политике.

- Удобный интерфейс с возможностью заниматься своими делами пока система делает парсинг запросов.

PromoPult 8.1

Ключевые идеи статьи

1. Не ограничивайтесь самыми очевидные ключевыми словами! Подберите релевантные, но нестандартные формулировки, которые принесут вам недорогие клики и конверсии.

2

Уделяйте большое внимание минус-словам. Чем полнее и ваш список минус-слов, тем меньше нецелевых показов и кликов получите

3. Информационные запросы используйте только если есть подходящие посадочные страницы для них. Генерировать прямые продажи по инфо-запросам будет сложно.

4. Пользы от больших семантических ядер нет. Для большинства кампаний несколько десятков или сотен запросов вполне достаточно, чтобы получить релевантный трафик по максимально низкой цене.

Если же у вас возникли трудности с подбором ключевых запросов для Яндекс Директ или Google Рекламы, или другие проблемы при запуске или ведении кампаний, обращайтесь к нашим специалистам.

Оффлайн парсеры

Возможность парсинга Яндекс Вордстат без доступа к интернету или при его низкой скорости – одно из требований к современным инструментам СЕО анализа. Технически это реализовано просто – на компьютер или аналогичное устройство, скачивается базы Wordstat и затем с помощью программы происходит выборка ключевых слов.

Букварикс десктопная версия

Впервые полноценный десктопный вариант представили разработчики «Букварикс». Однако уже в октябре 2017 года этот проект был «заморожен», ПО и базы данных не обновляются. Компания предлагает все инструменты в онлайн-режиме. Скачать приложение можно на старой версии официального сайта, использование бесплатное.

Что нужно учитывать при использовании десктопной версии:

- скачиваемый объем – около 30 Гбайт;

- скачать можно только с Яндекс.Диска, состоит из 20 частей;

- последняя дата обновления БД – 1 октября 2017 г.

Информация в этой версии устарела, возможно использование как вспомогательного инструмента.

Зачем нужен Kparser?

На официальном сайте найдете несколько полезных статей с описанием способов применения Kparser. Например:

- В Youtube — осуществляет подбор тегов и ключевых слов с «длинным хвостом» для видео, которые бы отлично охарактеризовали ролик и были максимально эффективны с точки зрения продвижения.

- Google — сбор подсказок под SEO и Adwords. Используя совместно сервисы Adwords Keyword Tool и Kparser, вы достигнете лучшего результата по выборке. Причем последний выдает в разы больше информации + доступен всем пользователями.

- Google Search Console — соединение данных из двух инструментов позволит улучшить показатели органического трафа. Собирайте релевантные подсказки для тайтлов/текстов имеющихся страниц либо делайте новые под ключевые запросы с хорошим потенциалом.

- Определяйте минус слова под ваши Adwords и Direct кампании.

- Google Search Trends — ищите трендовые направления для создания актуального контента + формируйте через Kparser фразы с длинным хвостом.

- eBay + Amazon — по аналогии с Youtube и другими нишевыми продуктами рассматриваемый проект помогает определять релевантные ключи и поднять ваш товар повыше в выдаче.

Советую хорошенько изучить все эти инструкции, т.к. там весьма детально рассмотрены ситуации, в которых Kparser позволит выжать максимум из того или иного сервиса. К сожалению, пока что информация представлена только на английском.

Возьмем к примеру Youtube…

По правилам хорошей оптимизации ролика вам нужно:

- придумать наиболее релевантный ключевой запрос для видео;

- использовать его в имени загружаемого файла, заголовке и других элементах на странице;

- создать хорошее описание с вашими ключевиками и похожими по смыслу фразами;

- добавить запросы в теги, по которым должны находить данное видео;

- напоследок поделитесь роликом во всех своих социальных аккаунтах и, возможно, попросите об этом друзей либо закажите небольшую рекламу — надо постараться сделать своего рода вирусный эффект после публикации.

Теги для видоса — очень важны. Если их не указываете, то получите нулевую оценку параметра vidIQ. С заполненными полями результат явно получше:

Теги добавляются дабы поисковики понимали о чем ваше видео и, соответственно, по каким запросам в Youtube оно будет ранжироваться.

Если у вас новый канал, старайтесь использовать менее конкурентные ключевики с длинным хвостом — так больше шансов побороться за трафик. Популярным авторам есть смысл вклиниться в борьбу по крутым тегам. Найти подходящие варианты вам как раз и поможет текущий инструмент.

Программы парсеры

Для точной обработки ключевых слов рекомендуется использовать программные комплексы. Преимущество – они работают напрямую с базами данных Ворстат. Полная версия платная, некоторые разработчики предоставляют демо-режим с ограниченным функционалом.

Кей Коллектор

Программа «Кей Коллектор» популярна среди разработчиков и СЕО-оптимизаторов. Причины – работа с популярными поисковыми системами, сегментация выборок по параметрам пользователя. Предоставляется только на платной основе, стоимость зависит от количества приобретаемых лицензий.

Особенности «Кей Коллектор»:

- Анализируется только актуальная статистика, сбор информации ведется напрямую из баз данных (БД) Яндекса.

- Ключевые слова подбираются по региону, частоте, сезонности.

- Учитываются стоп-слова.

Возможен многопоточный режим работы. Но есть вероятность получения бана или многократного ввода капчи при формировании нескольких потоков запроса информации с одного IP. Возможен сбор информации через Яндекс.Директ, что уменьшает скорость обработки.

Словоёб

Бесплатная альтернатива Кей Коллектор, но с меньшими функциональными возможностями. Отличие – «Словоёб» работает только с Вордстат. При анализе некоторых ключевых фраз могут не учитываться низкочастотные запросы, которые есть в статистике Яндекс.Директ. Глубина эффективного парсинга ограничена 40 страницами.

Особенности программы «Словоёб»:

- меньшие возможности работы с таблицами;

- нет «поисковых подсказок»;

- отсутствует сбор главных страниц выдачи;

- нет позиций по запросам.

Программа подходит для формирования СЯ небольшого проекта. Причина – скорость обработки полученных данных, нет углубленного анализа запросов.

Магадан

Технические ограничения в бесплатном варианте программы:

- нельзя выбрать региональность для запросов;

- отключены фильтры по количеству символов, слов;

- нет импорта файлов со стоп-словами;

- нельзя задавать правила к генерируемым ключевым фразам;

- отключен экспорт КС.

Несмотря на такие ограничения «Магадан» можно использовать для формирования СЯ 1-3 проектов. Но по отзывам пользователей по сравнению с ручной обработкой Вордстата теряются низкочастотные запросы.

UDPipe 2.0

описание архитектурырепозиторий с кодом обучениямануалпараметры обучения

Как работает UDPipe 2.0

- LeftArc — применим, если второй элемент стека не root. Сохраняет зависимость между токеном на верхушке стека и вторым токеном, а также выкидывает второй из стека.

- RightArc — то же самое, но зависимость строится в другую сторону, и отбрасывается верхушка.

- Shift — переносит очередное слово из буфера в стек.

источникссылке

Проблемы UDPipe

«Глокая куздра штеко будланула бокра и курдячит бокрёнка».Tagging from plain text (CoNLL17 F1 score)

- gold forms: 301639,

- upostag: 98.15%,

- xpostag: 99.89%,

- feats: 93.97%,

- alltags: 93.44%,

- lemmas: 96.68%

разработка яндексаинтересныхстатей

- «нет директора» — родительный падеж единственного числа

- «я вижу директора» — т.е. винительный падеж единственного числа

- «это какие-то директора» — именительный падеж множественного числа (ударения-то у нас на письме нет)

RNNMorphMorphoRuEval-2017russian_tagsetspackage

Версии навигатора и системные требования для Андроид

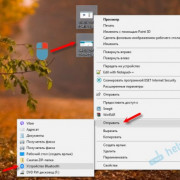

Способ 2. Собираем запросы «с хвостами» на площадках вопросов и ответов

Ответы Mail.ru, Тостер, The Question – хорошие источники «живых» НЧ-запросов.

Для примера зайдем на Тостер. Вводим в поиске запрос по нашей тематике – «как выбрать домен». В результатах поиска отобразятся похожие вопросы – их нам выгодно собрать и использовать как НЧ-семантику.

Естественно, вручную вопросы мы копировать не будем. Их также можно спарсить с помощью Xpath. Если мы используем Scraper, то последовательность действий будет такой:

-

Кликаем правой кнопкой мыши по любому вопросу.

-

В контекстном меню кликаем по пункту «Scrape similar…».

-

Парсер соберет все вопросы со страницы. Жмем «Copy to clipboard» и вставляем в файл с семантикой (Excel или Google Таблицу).

Если используете другой Xpath-парсер

Например, Screaming Frog SEO Spider.

Нужно получить Xpath-запрос, с помощью которого парсер соберет вопросы со страницы. Для этого кликаем правой кнопкой мыши по любому вопросу и выбираем пункт «Просмотреть код». Кликаем правой кнопкой по html-коду вопроса (подсвеченный фрагмент), жмем Copy → Copy Xpath.

Код запроса вставляем в парсер и загружаем URL страниц, на которых нужно собрать вопросы. Подробная инструкция по парсингу с помощью XPath в Screaming Frog SEO Spider – здесь.

Парсинг в Google Таблицах

Если вы не хотите искать и устанавливать бесплатные парсеры (или покупать Screaming Frog), используйте Google Таблицы. С помощью одной функции и Xpath-запроса вы можете спарсить любой элемент с практически любого сайта.

Функция и синтаксис:

=IMPORTXML(”URL”;”Xpath-запрос”)

Разместите URL страницы, которые хотите спарсить, в ячейке таблицы. А в формулу функции первым значением укажите адрес этой ячейки. Так вам будет удобнее работать с формулой, если нужно спарсить данные с нескольких URL.

В Google Таблицах много полезных формул, которые упрощают работу SEO-специалистам и тем, кто самостоятельно работает с семантикой. Больше таких формул вы найдете в .

Еще один способ собрать вопросы

Сервис AnswerThePublic подбирает широкий пул вопросов, слов с предлогами и похожих фраз на основе одного базового запроса.

Сервис англоязычный, но с недавних пор поддерживает русский язык и подходит для сбора русскоязычной семантики.

Как это работает

Заходите на сайт сервиса, выбираете русский язык, указываете ключевую фразу, для которой нужно подобрать запросы и жмете «Get Questions».

Сервис подбирает ключевики и визуализирует в таком виде:

Нажмите «Download CSV», чтобы выгрузить ключевые слова в таблицу.

Вот так выглядит таблица с выгрузкой подобранных ключей:

Кому нужен онлайн комбинатор?

Комбинатор для директолога – полезный инструмент для создания базисных списков запросов. Также с его помощью SEO оптимизатор может собрать до 100 000 ключевых слов и фраз для Директа, оптимизации сайта или для парсинга, обеспечив себе необходимую свободу действий в дальнейшем. Пересекатор работает в удобном формате, можно решить все задачи в режиме онлайн, не затрачивая много времени и сил. Конечно, без первичного “ручного” построения списка ключевиков для пересечений не обойдется. Но, используя данный скрипт, процесс удастся значительно ускорить.

Для чего необходим этот сервис? Генератор нужен для перемножения ключевиков – после того, как базовый набор запросов создан, потребуется соединение полученных слов в фразах. Веб-версия сервиса также весьма удобна при составлении семантики для Директа. В этом случае комбинатор справится с задачей по пересечению в максимально короткие сроки. Даже при максимальной загрузке пересекатора возможно лишь минутное ожидание.

Сколько ключевых слов должно быть в семантике

Несколько лет назад появились определенные обучающие курсы по контекстной рекламе, утверждающие, что большая СЯ на несколько тысяч или десяток тысяч ключевых слов дает больший охват и более низкую цену за клик. С тех пор существуют сторонники этого подхода и споры, хорошо это или нет.

Если коротко — это бесполезно, и даже вредно. Но в чем минусы кампаний с тысячами запросов?

- Подавляющее большинство таких запросов не дают ни показов, ни кликов. Даже если Wordstat на момент настройки кампаний показывает частотность >0, это всего лишь прогноз, и по факту 90-95% эти ключей не дадут ни одного показа.

- Из-за большого объема ключевых слов усложняется управление кампаниями, статистика по кликам и конверсиям «размазывается» по разным ключам.

- Может потеряться часть кликов. Большинству таким низкочастотным запросам присваивается статус «мало запросов» в Google и «мало показов» в Яндексе, и даже если есть по ним 1-2 показа в месяц, из-за этих статусов реклама не покажется. В Google с этим ничего не поделать и потеря кликов обеспечена. В Яндекс бороться с «мало показов» можно, но это требует определенных трудозатрат, от которых не будет никакой пользы. Большинство низкочастотников настолько длинные, что в заголовок объявления их не вставить, а в противном случае пользы от их добавления практически нет.

- При использовании семантического ядра на тысячи запросов тексты объявлений обычно генерируются автоматически, в следствие чего часть из них получается нечитабельным набором слов.

В наших кампаниях, в зависимости от ниши, используется примерно по 20-500 ключевиков. Этого достаточно, чтобы охватить целевую аудиторию и получать клики по минимально возможной цене. Больше (несколько тысяч или десятков тысяч) бывает только у клиентов с большим ассортиментом товаров или большим количеством услуг.

Перечень функций:

| Light Edition | ||

|---|---|---|

| Автоматическое распознавание тела статьи на странице любого сайта, при условии, что на странице есть текстовый контент | ||

| Удобное редактирование и ручная проверка отпарсенного контента при помощи менеджера обработки контента | ||

| Возможность парсить контент без разметки (под генераторы дорвеев и т.п.) | ||

| Возможность парсить контент с сохранением исходной разметки (выделения, заголовки и т.п.), как с изображениями и возможностью их сохранения, так и без. | ||

| Возможность парсить статьи по списку ключевых слов | ||

| Возможность парсить статьи по списку ссылок | ||

| Возможность добавлять и парсить любые поисковые системы | ||

| Возможность парсить текст на любых языках, добавив поисковые систем с нужными языковыми настройками | ||

| Свободная настройка абсолютно любого формата вывода статей для дальнейшего экспорта контента с помощью любых приложений для постинга контента, например Zebroid, Textkit или напрямую в WordPress. | ||

| Парсер умеет автоматически определять капчи поисковых систем. Не зависимо от того какую ПС Вы добавите парсер самостоятельно определит ее и отправит ее на распознавание, например в сервис Rucaptcha или любой другой. | ||

| Возможность на стадии сбора контента фильтровать по собственным фильтрам как статьи так и отдельные абзыцы, а так же заменить или удалить любые включения как по точным условиям, так и с помощью регулярных выражений. | ||

Советы и рекомендации по использованию программ для парсинга

Специалисты советуют сочетать ручной и автоматический выбор запросов для составления семантического ядра, особенно для новичков. Пользуясь штатным инструментом Яндекс Вордстат Ассистент, вы нарабатываете навыки интуитивного подбора поисковых фраз, которые приводят на сайт целевых клиентов с помощью средне- и низкочастотных ключей. Высокочастотные фразы не всегда работают, особенно в конкурентной нише.

Если у вас нет времени на ручной парсинг в Яндекс Вордстат, используйте специальные инструменты. В интернете можно найти различное программное обеспечение, но большинство русскоязычных специалистов по SEO-оптимизации делают парсинг выдачи Яндекса с помощью Key Collector.

Это десктопный продукт, позволяющий создавать и хранить в локальной памяти компьютера проекты для каждого сайта, загружать и сохранять файлы и делать парсинг ключевых слов в соответствии с региональными настройками. Программа требует привязки к аккаунту. Для работы с ключевыми поисковыми запросами в Кей Коллекторе имеются пиктограммы основных поисковых систем в Рунете (в нашем случае это Yandex-парсер, хотя можно выбрать Google, Bing и другие).

Среди других полезных сервисов для SEO такие:

- Serpstat – многофункциональная платформа для профессионалов, имеющая триальную версию с ограниченным функционалом, а также платную подписку от 19 до 299$ в месяц;

- Ahrefs – веб-сервис с множеством полезных опций, включая мониторинг ниши, анализ конкурентов и улучшение индексации сайта. Для сбора семантического ядра предусмотрен инструмент Keywords Explorer. Протестировать его можно от 7$ в неделю;

- Semrush — аналог Ahrefs по части функционала, более дорогой по тарифам (от 99$ и выше).

Специалисты утверждают, что Кей Коллектор – это самая удобная и функциональная программа, позволяющая значительно облегчить жизнь оптимизатора. У нее есть множество полезных опций для точной настройки параметров парсера Yandex (например, глубины поиска, избирательного поиска запросов по базовой частотности и т.п.).

Но у программы есть нюанс – она платная. Стоимость лицензии составляет 1800-1900 рублей по электронному и безналичному расчету соответственно.

Совет! Если по какой-то причине вы не хотите пользоваться этим продуктом, можете попробовать его бесплатный аналог «Словоёб». Подойдет и более простой вариант — Букварикс – бесплатный сервис для сбора ключевых слов и формирования семантического ядра.

Парсинг Яндекс Вордстат можно делать самостоятельно и с помощью специальных программ. Ручной сбор посредством инструмента Wordstat Assistant оправдывает себя в том случае, если ваша ниша имеет узкую направленность и мало конкурентов, а перечень поисковых запросов относительно невелик. При больших объемах работ рекомендуется пользоваться специальными программами для парсинга и аналитики.

Плюсы и минусы работы с Кей Коллектором

Еще один вариант – сбор парсером KeyCollector (КК). Эта программа покупается один раз, причем по вполне сходной и доступной цене, а затем используем бесплатно.

При больших объемах КК очень сильно подгружает Ваш ПК, да и скорость сбора данных у него низкая. Поэтому мощность компьютера, на котором Вы хотите парсить большие объемы должна быть соответствующей.

Для настройки многих операций сбора КК может потребовать определенных умственных усилий и хлопот при подключение разных аккаунтов, прокси-серверов, работе с капчей и т.п.

Но без этого получить данные без ощутимых материальных затрат не получится.

Я использую KeyCollector при работе над СЯ в основном на этапе чистки собранных ключей от мусора, дублей и т.п..

Программы и сервисы для парсинга

Для начала нужно подобрать около 20 базовых фраз. Для этого используем свой мозг (подумайте, какие словосочетания ассоциируются с вашим родом деятельности), поисковую выдачу по схожим запросам и данные из Яндекс.Метрики и Google Search Console (смотрим, по каким ключам больше переходов на ваш сайт).

Далее для создания хорошего семантического ядра используем специальные программы.

Бесплатные

Часть работы можно проделать, не заплатив ни копейки. Здесь на помощь приходят определенные сервисы.

Wordstat Yandex

- показывает количество и частоту запросов в Яндексе;

- фразы изменяются в падежах;

- можно задать регион;

- позволяет сделать выборку по типу устройства (ПК, планшет, смартфон);

- позволяет исключить лишние фразы.

Планировщик ключевых слов Google

- подходит для узкой тематики;

- позволяет собрать широкую базу ключей;

- показывает статистику по словам;

- прогнозирует эффективность фраз.

Букварикс

- содержит большую базу запросов;

- функции фильтрации минимальны.

При использовании бесплатных ресурсов семантическое ядро получается «грязным» — словосочетания дублируются, выдаются нерелеватные запросы, слова с нулевой частотностью, которые приходится чистить с помощью фильтров или вручную.

Платные

Для расширения ядра советуем воспользоваться платными сервисами.

Rush Analytics

- автоматизирует сбор и группировку значимых словосочетаний;

- парсит запросы через Wordstat;

- регулируемая глубина поиска;

- классифицирует запросы по типам (коммерческие и информационные).

База Пастухова

- большая база ключевых слов (на русском и английском языке);

- фильтрует запросы по числовым данным;

- есть онлайн-версия;

- из-за дороговизны больше подходит крупным компаниям.

Serpstat

- комплексный сервис для продвижения ресурса;

- выделяет запросы, по которым проект попадает в ТОП-100 выдачи;

- возможность анализировать сайты конкурентов.

Для наибольшей эффективности советуем комбинировать бесплатные и платные сервисы.

Общие выводы

- Не так страшен чёрт, как его малюют. Создание парсера с помощью инструмента, дело, в общем, посильное. Достаточно изучить общие принципы и потратить полдня на изучение конкретного инструмента, после чего в дальнейшем все уже будет намного проще. А вот велосипеды изобретать — не надо. Особенно, если вам не особенно важна скорость парсинга и оптимизации.

- Грамматики имеют собственную ценность. Имея перед глазами грамматику, гораздо проще оценить, будут ли при использовании составленного по ней парсера возникать ошибки.

- Инструмент можно найти всегда. Возможно, не на самом привычном языке, но почти на всех они есть. Если не повезло, и его все-таки нет, можно взять что-нибудь легко используемое (что-то на js, python, lua или ruby — тут уж кому что больше нравится). Да, получится “почти stand-alone в рамках проекта”, но в большинстве случаев этого достаточно.

- Все инструменты (немного) различаются. Иногда это “:” вместо “=” в BNF, иногда различия более обширны. Не надо этого пугаться. В крайнем случае, переделка грамматики под другой инструмент займет у вас минут 20. Так что если есть возможность достать где-то грамматику, а не писать её самому, лучше это сделать. Но перед использованием все равно лучше её проверьте. Все мы люди, всем нам свойственно ошибаться…

- При прочих равных, лучше используйте более “разговорчивый” инструмент. Это поможет избежать ошибок составления грамматики и оценить, что и как будет происходить.

- Если для вас в первую очередь важна скорость разбора, боюсь, вам придется либо пользоваться инструментом для C (например, Bison), либо решать проблему “в лоб”. Так же, следует задуматься о том, нужен ли вам именно парсинг (об этом стоит задуматься в любом случае, но в случае скоростных ограничений — особенно). В частности, для многих задач подходит токенизация — разбиение строки на подстроки с использованием заданного разделителя или их набора. Возможно, это ваш случай.