Что такое траст сайта, как проверить траст сайта и увеличить трастовость ресурса?

Содержание:

- Как определить траст

- Как проверить Траст сайта.

- Что такое траст сайта? Трастовые сайты

- 4 главных заблуждения о продвижении сайта

- Канонические ссылки и дубли

- На что влияет траст сайта?

- Версия 5.0.21

- Что влияет на траст сайта

- Зачем повышать авторитетность?

- 89 вопросов по настройке MikroTik

- Как повысить XT площадки

- На что он влияет

- Начальник производства (в сельском хозяйстве)

- Вклады Траст банка

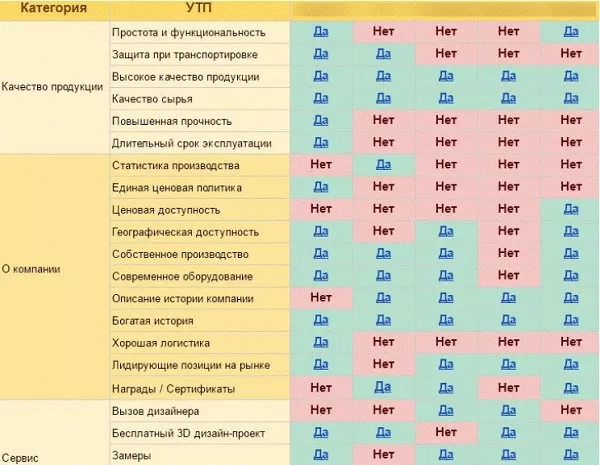

- Некоторые из анализируемых показателей:

- Striped rows

- Как профилирование Google отражается на практике

- Март и апрель

Как определить траст

Четкого алгоритма определения этого показателя нет. Поисковые системы не раскрывают своих алгоритмов, поэтому оценить траст того или иного проекта очень сложно. Достоверных данных очень мало.

К счастью, есть несколько онлайн-сервисов, которые помогают узнать траст сайта. Сервисы используют определенные формулы, где учитываются ранее обозначенные переменные: количество ссылок, посещаемость, скорость загрузки, позиции в поисковиках и т. д.

Достоверно ли это, сказать точно нельзя. ПС развиваются, поэтому актуальность этих данных может оставаться под вопросом. Но вы все равно можете оценить свой проект:

XTool

Простой сервис на русском языке. Помогает определить показатель траста сайта. Достаточно зайти, ввести нужный URL и кликнуть по кнопке “Проверить”. Для ознакомления доступны 12 вкладок с информацией по сайту. Там есть и про ссылки, и про посещаемость, и про другие факторы, которые участвуют в расчете траста.

CheckTrust

Еще один сервис, который может помочь в анализе траста ресурса. Работает точно по такому же принципу, что и предыдущий – зашли, ввели ссылку, кликнули по кнопке. Здесь есть ограничение в 500 проверок, но этого будет достаточно для большинства пользователей – тех, кому не надо проверять по несколько тысяч адресов ежедневно.

Если же вам будет недостаточно 500 бесплатных проверок, то вы можете оплатить ежемесячный тариф. Самый дешевый – 960 рублей в месяц. Предполагает 10 000 проверок. Есть и более дорогие тарифы.

Как проверить Траст сайта.

Чтобы проверить траст сайта, Вам достаточно воспользоваться одним и онлайн-сервисов. На сегодняшний день количество таких сервисов исчисляется десятками, а то и сотнями.

Описывать каждый из них, нет ни какого смысла. Поэтому я остановлюсь на том, который сам постоянно использую.

Для проверки траста сайта я обращаюсь к сервису Xtool.ru. На мой взгляд, это довольно адекватный ресурс, который оценивает необходимых мне доноров по 10 бальной шкале, отображая все их качественные показатели (Тиц, PR, количество ссылок, число посетителей и т. д.).

Это экономит мне кучу времени, так как сводит на нет необходимость использования дополнительных программ и сервисов проверки траста. Здесь, как в рекламе шампуня — всё в одном флаконе.

На проверку траста сайтов Вам отводится определённое количество бесплатных запросов, которые всегда можно прикупить за мизерную цену (100 запросов за 15 рублей).

Проверить работу сервиса и необходимый Вам сайт можно прямо сейчас, воспользовавшись специальной формой ниже:

Проверка Траста

Так же для дальнейшего анализа сайта необходимо взглянуть на дизайн и качество размещённых на страницах донора материалов. Например, бессмысленные тексты недвусмысленно намекают на то, что размещать здесь ссылку на свой проект – не совсем правильное решение.

Ещё Вас должно насторожить обилие агрессивной рекламы. Чаще всего такие сайты уже находятся под фильтрами и закупка ссылок на их страницах – пустая трата средств. Не в пользу ресурса говорит и отсутствие или нерегулярность обновлений. Если в ленте новостей последняя появилась несколько месяцев назад – грош цена такому донору.

Лучше всего о сайте расскажет статистика его посещаемости (как установить счётчик посещений). Как правило, владельцы ресурсов, которым нечего скрывать, оставляют счётчики открытыми для просмотра потенциальными рекламодателями. Таким образом, заинтересованное лицо может получить исчерпывающую информацию об источниках трафика и среднесуточном количестве посетителей и просмотров страниц. Желательно, чтобы дневная аудитория сайта-донора составляла не менее сотни человек. Так же не будет лишним проверить сайт на плагиат.

Трату времени на изучение площадки, которую Вы решили использовать для размещения собственных ссылок, ни в коем случае нельзя рассматривать, как напрасную. В конце концов, Вы должны знать, за что платите деньги. Да и в результатах хочется быть уверенным

Кстати, это один из аргументов в пользу того, чтобы заниматься раскруткой сайта самостоятельно, а не предоставлять это дело «профессионалам», для которых нет более важного показателя, чем значение ТИЦ и количество страниц в индексе «Яндекса»

Теперь зная как проверить траст сайта и оценить качество донора, Вы самостоятельно сможете справиться с отбором достойных площадок не хуже любого специалиста.

На сегодня это всё. До новых статей…

Что такое траст сайта? Трастовые сайты

Определение «трастовый» происходит от английского слова «Тrust», что в переводе означает «доверие.» Еще его называют «ТrustRank» — показатель доверия. Это один из наиболее важных факторов ранжирования сайтов в поисковой выдаче.

В интернете существует множество сайтов, которые имеют большое доверие (высокий траст) у поисковых систем. Еще их можно назвать «Трастовые сайты». К ним относятся очень популярные сайты: Wikipedia, twitter и т.п. Иметь ссылки с таких сайтов — это круто!

Наличие таких ссылок способствует повышению доверия поисковых систем к вашему сайту, поднимает его авторитет в глазах поисковиков. Другими словами, ссылки с трастовых сайтов повышают траст вашего сайта. Конечно, одних ссылок будет мало, трастовость сайта зависит от многих факторов. Давайте попробуем понять: что же повышает доверие к сайту помимо ссылок.

Скажу сразу, моему блогу меньше месяца, его я исключаю. Второму — 1 год 11 месяцев, третьему – 10 месяцев. Определить возраст домена можно Для чего я написал возраст, надеюсь понятно, доверие приходит с годами :-).

Из анализа можно выделить параметры, которые влияют на трастовость сайта:

— количество внутренних и внешних ссылок; — посещаемость (трафик); — наличие санкций от поисковых систем (в данном случае — Яндекса); — ТИЦ и PR сайта. Из скриншотов видно, что сайт №2 имеет лучшие показатели во всех графах по сравнению с сайтом №3. Однако его xt меньше. Из этого следует, что помимо этих показателей, имеется еще ряд факторов, участвующих в оценке траста сайта.

А теперь давайте разберемся, что же может влиять на доверие поисковых систем к нашему сайту:

1. Возраст сайта. Тут сомнений быть не может. Чем старше сайт, тем больше к нему доверия. В данном случае учитывается не возраст домена, а возраст, прошедший с момента первой индексации сайта.

2. Посещаемость. Здесь все понятно. Чем больше посещаемость, тем больше траст.

3. Ссылки на сайт. Учитываются внешние ссылки на сайт. Вероятно, поисковые системы придают значение только тем ссылкам, которые они засчитали как естественные. Из «мадридского доклада» известно, что Яндекс умеет отличать продажные (коммерческие) ссылки от некоммерческих. Сомнений нет в том, что Google их тоже умеет различать.

4. Исходящие ссылки. Ссылки с вашего сайта на хороший, авторитетный сайт –это хорошо. Ссылки на говносайт (ГС) – плохо.

5. Качество сайта. Здесь важную роль играют множество факторов: — хороший качественный контент; — внутренняя оптимизация сайта; — качество хостинга, на котором расположен ваш сайт; — скорость работы, загрузка страниц; — качество кода сайта (наличие в нем ошибок).

6. Наличие сайта в трастовых каталогах, таких как Яндекс и Dmoz. Здесь перечислены далеко не все факторы, влияющие на авторитет сайта. Их, конечно же, намного больше. Но я думаю, что эти основные и самые важные.

И сейчас, зная все эти факторы, давайте ответим на вопрос:

4 главных заблуждения о продвижении сайта

Чтобы не наделать ошибок в продвижении, необходимо сразу избавиться от некоторых заблуждений и устаревших взглядов на раскрутку и оптимизацию.

Изучаем ТОП-4 заблуждений.

Заблуждение 1. В моей нише много сайтов, поэтому пробиться в ТОП-10 невозможно

На деле очень даже возможно, хотя нужно будет приложить усилия. Следуйте указанным выше рекомендациям — «копайте в этом направлении» и не гонитесь за сверхпопулярными запросами.

Заблуждение 2. Я попал в ТОП-3 – можно ничего не делать

Увы, но попадание в ТОП ещё не гарантирует безоблачного будущего.

Позиции поисковой выдачи меняются ежедневно: чтобы оставаться на плаву, необходимо работать над оптимизацией постоянно. Сами алгоритмы поисковиков тоже периодически обновляются: отслеживать их эволюции – дело профессиональных SEO-специалистов.

Заблуждение 3. Нужно обязательно купить дорогой дизайн для сайта

Дорогой дизайн сам по себе не гарантирует успеха. Люди с большими деньгами заказывают оформление сайта в студии Артемия Лебедева или Hungry Boys и всё равно не попадают в ТОПы поисковых систем. Другие обходятся аккуратным и скромным дизайном от фрилансера с биржи и набирают миллионы посетителей.

Дороговизна дизайна сайта абсолютно не гарантирует продвижения в ТОП

Дороговизна дизайна сайта абсолютно не гарантирует продвижения в ТОП

В чем сила? Она — в SEO.

Заблуждение 4. Буду покупать много ссылок каждый день, и сайт станет популярным

Не факт, а скорее даже наоборот. Если покупать ссылки неграмотно и в больших объёмах, возникнет переоптимизация (ссылочный спам). Каков результат? Вашему сайту это повредит. Особенно вредно приобретать ссылки на ранних этапах раскрутки сайта.

И не нужно захламлять свой сайт контекстной рекламой и тизерами. Такой портал быстро вылетит из ТОПа поисковиков, даже если туда попадёт.

Чем нужно заниматься серьезно и постоянно — так это улучшением поведенческих факторов. Это отказы, глубина просмотра, время на сайте и т.д. Пользователям должен нравиться ваш сайт!

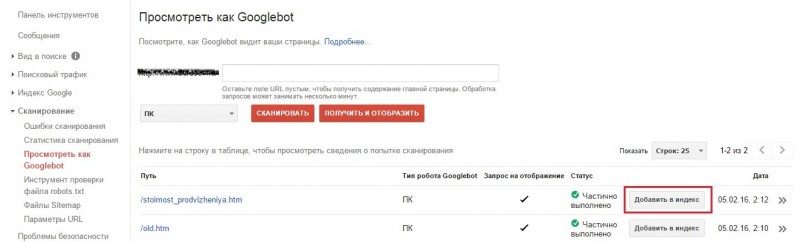

Канонические ссылки и дубли

Некоторые нюансы продвижения сайтов в Google SEO-специалисты могут определять в ходе экспериментов или догадок на основе опыта.

Представим ситуацию: на сайте выложили документ, а потом владельцы нескольких других ресурсов разместили его на своих сайтах. Какой из ресурсов Google будет считать каноническим, а какие дублями?

Логично предположить, что оригиналом будет считаться файл на сайте, на котором он появился первым. Но это не так: если в сети появилось несколько копий одного документа, каноническим считается наиболее авторитетный URL. Остальные считаются дублями, причем входящие ссылки на них становятся входящими ссылками на канонический документ. Это называется инвертированием ссылок.

Мы не сталкивались с этим в практике, но оптимизаторы, работающие в буржунете, отметили такую особенность.

Допустим, вы выкладываете в своем блоге pdf-файл с чек-листом или шаблоном контент-плана, который сами составили. Через пару дней несколько других блогов размещают документ у себя. Если ваш ресурс самый авторитетный из них, то будет считаться каноническим, а URL копипастеров окажутся дублями, и ссылки на них будут засчитываться вам. Ссылки на дубли вместе с другими ссылками на ваши страницы будут отображаться в Search Console.

Для владельцев сайтов это хорошо: чем больше ресурсов ворует ваш контент и размещает у себя, тем больше ссылок вы получите. Но это работает, только если ваш URL самый авторитетный из них. Если Google обнаружит этот же документ на чьем-то более авторитетном сайте, то ваш окажется дублем, и все ссылки начнут продвигать тот ресурс.

На что влияет траст сайта?

Первое и, наверное, самое важное — это продвижение ресурса в поисковиках. И второе, траст воздействует на ранжирование

Вот почему имеет такую важность этот показатель среди вебмастеров. Если взять цифры, который нам выдал вышеописанный онлайн-сервис, то — это лишь приблизительный показатель всей имеющейся картины определенного сайта

На самом деле этот показатель не имеет числового выражения как мы привыкли видеть. Так как ни одна система из поисковиков не открывала карты, о таких вещах, как, на какой сайт она полагается, а какой нет.

К примеру, можно взять всем хорошо известную Википедию. Наверняка когда вы в поиск вписываете интересующуюся вам запрос видели в выдаче на первом место именно Википедию. Вот это и есть пресловутое доверие к сайту. Было бы неплохо иметь именно с такого сайту ссылку.

Версия 5.0.21

Инструкция для новичковрекомендаций

-

Возможность

многопоточной неограниченной бесплатной проверки

таких параметров как

- PR, Tic Page Rank Google, Тиц Яндекса

- YP, YL,YC — проверка индексации страниц и ссылок (также определяется титл страницы по Яндексу) и проверка наличия и даты сохранённой копии.

- ВС — проверка количества внешних и внутренних ссылок на странице, определение блоков ссылок (оранжевым), размера текста страницы, description и поиск заданных стоп-слов в тексте (кнопка отмечается пурпурным)

- LVL — проверка уровня страницы

- POS — позиция вашей ссылки на странице (от 0 до 1, чем больше тем ниже), вообще наличие ссылки (подставляется юзер-агент Яндекса) и размер текста после ссылки

- TrF — проверка количества посещений а также отношение просмотров к посещениям (используются данные li)

- GP,GL,GC — проверка индексации страниц и ссылок в гугле, а также наличия в кеше гугла

- BgP,BgL — проверка индексации страниц и ссылок в бинге

- inY, inG — проверка количества страниц сайта в индексе Яндекса и Google

- AR — Alexa Rank по данным сервиса Alexa.com

- MzR — MozRank и Page Authority по данным сервиса Seomoz.org

- R — регион сайта в Яндексе

- RLV — релевантность сайта-донора указанным ключевым словам.

- 17 режимов — для sape.ru, для seopult, для liex, для xap, для blogun.ru, для linkfeed.ru, для mainlink, для gogetlinks, для rookee, webeffector,seohammer, megaindex, solomono, rotapost, setlinks, miralinks и для остальных сайтов (просто вставляет кнопки рядом со ссылками) и автовыбор (обычно достаточно поставить этот режим)

- Проверка трастовости XT для страницы и XTD для домена (главной страницы) — Для отбора доноров и отсева ГС

- Массовая проверка в несколько потоков кнопок XT XTD YP YL ВС LVL POS TrF Tic PR AR MzR R inY inG YC GC GP GL BgP BgL

- Ведение единого блэк листа (GBL) некачественных сайтов, добавление в GBL по клику на кнопке.

- Автоматическая отметка ссылок в соответствии с заданными настройками, для последующего отклонения (работает как при ручной, так и при массовой проверке)

- Кеширование результатов для отображения в следующий раз несколько другим цветом (архивный результат)

- Отметка возможных санкций при проверке XTD — жёлтым цветом.

- Импорт своих списков урл для массовой проверки по любым параметрам.

- Экспорт результатов в Excel.

- Addurl Яндекса списка урл.

Примеры оттветов кнопок сервиса:

- XTNO — не в индексе / успешно — число / архивное значение (сохранённое на компьютере)

- YPСтраница в индексе / страница не в индексе

- YLСсылка в индексе / ссылка не в индексе

- ВСКоличество внешних/внутренних ссылок на странице.

- POS

- TrF

- GP,GL,GC

Пример: Чистим список ссылок от ГС

Примеры использования кнопок POS и ВС:

Рекомендации оптимизаторам

История изменений:

Если вы ещё не зарегистрированы — для полноценной работы зарегистрируйтесь в сервисе. (Это вас ни к чему не обязывает, просто для получения логина и пароля) и залогиньтесь в сервисе (с главной страницы) в браузере Firefox

СКАЧАТЬ Плагин от XTOOL.RU для Firefox

ВНИМАНИЕ! Это не архив, распаковывать его не нужно!

Список всех версий плагина, в том числе еще не утвержденные компанией Firefox Список версий

Что влияет на траст сайта

Когда я говорил, что это мифический показатель, то это было не для красного словца. Дело в том, что понятие это очень уж обросло мифами и легендами. Существует аж три основных теории, объясняющих принципы работы данного показателя сайта. Все они являются даже не теориями, а скорее предположениями, что здесь правда, а что ложь решайте сами, итак…

Теория 1

Некоторые полагают, что все дело в человеческом факторе. Мол, доверие к ресурсу растет не в автоматическом, а ручном режиме. Некоторые специалисты, работающие в поисковых системах, попросту выбирают качественные, по их субъективному мнению, ресурсы и повышают им показатели.

Далее система работает следующим образом: получивший доверие сайт делится им с теми сайтами, на которые ссылается. Те сайты, в свою очередь, тоже на что-нибудь ссылаются и также передают часть доверия. Все это продолжается по цепочке бесконечно.

В итоге получается, что каждый сайт имеет чуть ли не с момента создания свой некоторый «траст». Легенда или правда? А кто его знает…

Теория 2

Такое ощущение, что вторая является итогом воспаленного мозга одного веб-мастера, которому позвонил кто-то и рассказал свои соображения по поводу первой теории. В результате не очень внимательно слушавший веб-мастер где-то что-то понял, а где-то что-то придумал сам. Итог читайте сами.

Все также были выбраны сайты, соответствующие каким-то определенным параметрам. Они были разделены на несколько групп, каждой из которых присваивалось некоторое количество доверия в зависимости от величины этих «каких-то» показателей. Среди ресурсов одной группы машина пыталась найти некую связь, определенный закон или алгоритм работы. Он помогал «раздать» доверие всем оставшимся сайтам.

Теория 3

Наиболее любопытная с точки зрения здравого смысла. Суть ее заключается в том, что трастовость сайта — это некая совокупность параметров, вычисляемая путем их перемножения. Почему не суммы? Дело в том, что если одно из слагаемых будет низким, то это не слишком повлияет на итог, верно? А если один из множителей равен нулю? Вспомните математику за 2 класс.

Так или иначе, но в результате множества практических изысканий, обращений к магии вуду и битью в бубен было выяснено, что на траст сайта влияют следующие данные ресурса:

- Возраст сайта (именно самого сайта, отсчет начинается с момента его индексации).

- Зона домена ресурса.

- Устойчивая ссылочная масса (имеется ввидуто количество сайтов, на которых есть ссылки на ваш ресурс и они не изменяются в течение долгого периода времени).

- Объем ссылок (у ресурса, на который ссылается большое количество других сайтов, доверие куда выше).

- Доверие тех сайтов, которые на вас ссылаются. Если на вас ссылаются мощные трастовые ресурсы, это явно положительно сказывается на вашей репутации. Данное утверждение верно и наоборот: если на вас ссылается какой-нибудь ресурс, вовсе исключенный из индекса, то доверия к вам ровно ноль.

- Старое доброе наполнение. Контент должен быть свеженьким и уникальным, чтобы доверие к сайту возросло. Если же иметь ввиду количественный показатель, то речь идет об отношении уникального контента к его общей массе. О том, как проверить уникальность статей, читайте здесь.

- Наличие/отсутствие ссылок с вашего сайта на ресурсы, не имеющие доверия (под фильтрами или выбитые из индекса).

Многие веб-мастера сходятся во мнении, что важен также и пользовательский фактор. Чем дольше люди находятся на сайте, совершают какие-либо действия, оставляют комментарии, создают темы и так далее, тем больше они доверяют сайту, а значит, и поисковая система также повысит траст ресурса.

Теперь же я предлагаю рассмотреть один полезный ресурс, который дает возможность вычислить один достаточно важный параметр, к сожалению, назвать его трастом в чистом виде нельзя, и тем не менее.

Зачем повышать авторитетность?

- Если сайт отличается высокой авторитетностью, то при прочих равных у него меньше шансов попасть под санкции поисковых систем.

- В теории, у авторитетного ресурса больше шансов пробиться в ТОП поисковой системы. Однако доказать или опровергнуть это на практике нельзя, так как системы скрывают механизмы работы алгоритмов ранжирования.

- Если сайт предлагает размещение рекламных статей и ссылок, то авторитетность важна. Заказчики выбирают площадки, опираясь в том числе и на этот показатель.

Авторитетность сайта — размытое определение, которое используется для обобщенной оценки качества ресурса и его надежности с точки зрения поисковых систем. Практического применения эти цифры сами по себе не имеют, хотя и важны для оценки. Если говорить о том, как повысить авторитетность сайта, то ответом будет планомерная оптимизация ресурса, его развитие, улучшение юзабилити и повышение скорости работы, а также наполнение качественным контентом.

См. также: Аудит сайтаБелые методы поисковой оптимизацииВИЦВозраст страницыУровень вложенностиТеги-заголовки

89 вопросов по настройке MikroTik

Как повысить XT площадки

Следует еще раз уточнить, траст сайта по версии Xtool не равнозначен трасту в Яндексе, а предназначен конкретно для практической закупки более-менее качественных внешних ссылок, полезных для продвижения в поисковых системах.

То есть, веб-мастера XT своего проекта может интересовать не столько с точки зрения поискового продвижения, сколько в коммерческом плане продавать ссылки дороже, в большем количестве и быстрее.

Алгоритм вычисления XT является закрытым, как и Yandex Trust Rank. Однако разработчики указали, что индекс доверия Xtool разрабатывался на основе представлений об алгоритмах Яндекса и с использованием данных о практическом продвижении сайтов в рунете при помощи SEO-ссылок.

Следовательно, для повышения XT необходимо предпринимать аналогичные мероприятия, как и для улучшения позиций в выдаче Яндекса. То есть, работать над улучшением всех тех факторов, влияющих на авторитет площадки, которые были описаны в предыдущих разделах этого исследования.

На что он влияет

Вы могли уже догадаться, что траст влияет на позиции ресурса в поисковой выдаче. Предпочтение отдается наиболее трастовым проектам с хорошими показателями качества. Сайты низкого качества, наоборот, понижаются в поисковой выдаче в силу того, что ПС стремятся выдавать пользователям только полезную информацию.

Проекты с хорошим трастом могут рассчитывать на быструю индексацию материалов при помощи быстроботов – технологии Яндекса, которая индексирует материал за считаные минуты. Такая фишка будет особенно полезна для новостных сайтов. Статья залетает в выдачу практически моментально. Поэтому владельцам новостных порталов надо заботиться о повышении уровня траста особенно сильно. Это может помочь в привлечении большого количества трафика.

Также владельцы трастовых сайтов могут забыть о фильтрах или пессимизации от поисковиков. Сайт будет в топе, независимо от каких-то внешних факторов. Трастовым сайтам даже могут простить какие-то незначительные “косяки”. То есть простому ресурсу прилетит фильтр, а трастовый получит снисхождение.

Ранее трастовые сайты без проблем принимали в различные каталоги. Типа того же Яндекс.Каталога или его аналогов. Сейчас необходимость в таких штуках отпала, но Яндекс уже выкатил новую систему – Радар. В топ попадают самые популярные и трастовые сайты.

Начальник производства (в сельском хозяйстве)

Вклады Траст банка

Существуют доступные вклады Траст банка для физических лиц в 2018 году, проценты их очень выгодны для клиента и крайне доступны. оформить вклад в компании можно в любом офисе банка в любом городе — доступны выгодные вклады в Москве, вклады в Смоленске, простые и доступные вклады Траст банка в Рязани, а также в следующих городах:

- Петербург;

- Мурманск;

- Тверь;

- Москва;

- Липецк;

- Владимир;

- Череповец;

- Ярославль;

- Калининград;

- Петрозаводск.

Вклады Траст банка в 2018 году крайне разнообразны и доступны для каждого. Все вклады обладают хорошими процентными ставками. Здесь можно найти и доступные вклады Траст банка для пенсионеров и оформить ипотеку и получить выгодные процентные ставки по вкладам . Депозиты помогают быстро и просто накопить сбережения на свою мечту. Вклады в банке Траст на сегодня и подробные проценты по вкладам следующие:

- «Основной доход online»

Ставка в 6,23% с возможностью капитализации и ежемесячными пополнениями. - «Основной доход»

Ставка в 6,01%, дает ежемесячные начисления и возможность капитализации. - «Активное пополнение online»

Ставка 5,97%, дает возможность пополнения и капитализации. - «Активное пополнение»

Процентная ставка 5,76%, предоставляет возможность к пополнению и капитализации. - «Свободное управление online»

Ставка 5, 67%, предоставляет ежемесячные начисления. - «Свободное управление»

Ставка в 5,46%, предоставляет частичное снятие средств и возможность капитализации. - «До востребования»

Предоставляет ежегодные начисления, процентную ставку в 0,10% и частичное снятие средств.

Подробнее о вкладах можно узнать на сайте компании.

Некоторые из анализируемых показателей:

- Хост — url сайта без www и http://;

- Главное зеркало (по версии Яндекса);

- ТРАСТ (авторская формула);

- СПАМ (авторская формула);

- тИЦ;

- PR;

- Индексация;

- Каталог mail.ru — присутствие ресурса в каталоге list.mail.ru;

- WebArchive — дата первой отметки о сайте в сервисе web.archive.org;

- Регистрация домена — когда зарегистрирован в whois;

- Yandex Wordstat — сколько раз в месяц упоминалось имя сайта;

- Solomono — эти данные берутся с сервиса solomono.ru;

- Majestic — эти данные берутся с сервиса majesticseo.com;

- SeoMoz — эти данные берутся с сервиса opensiteexplorer.org (moz.com);

- LiveInternet.ru;

- Alexa.com;

- Yandex Blogs;

- Vkontakte;

- Google +;

Остановлюсь подробнее на 2 самых важных показателях программы.

Striped rows

Use to add zebra-striping to any table row within the .

| # | First | Last | Handle |

|---|---|---|---|

| 1 | Mark | Otto | @mdo |

| 2 | Jacob | Thornton | @fat |

| 3 | Larry | the Bird |

| # | First | Last | Handle |

|---|---|---|---|

| 1 | Mark | Otto | @mdo |

| 2 | Jacob | Thornton | @fat |

| 3 | Larry | the Bird |

Как профилирование Google отражается на практике

Хорошо, предположим, Google действительно говорит в блог-посте про авторитетность сайта и профилирование для улучшения поисковой выдачи. Что дальше? Из всего этого мы с вами можем сделать два важных вывода.

1. Очень внимательно следите за супер-авторитетными проектами в вашей нише

Не ждите Гугл. Не сидите, сложа руки, пока поисковик пытается создать профиль идеального сайта в каждой нише. У вас здесь огромное преимущество. И заключается оно в том, что вы – человек! Пока машинное обучение принесёт свои плоды, опытный вебмастер сто раз успеет наклепать профили лидеров в каждой индустрии.

Возьмите разные типы страниц лидеров и посмотрите, что они там делают.

Вот вам ещё один конкретный пример подобного анализа от «Rank Ranger». Специалисты сравнили лидеров медицинской отрасли с отстающими. Предметом исследования были заголовки информационного контента о здоровье.

В кейсе прослеживается чёткая грань между топами и лузерами. Авторитетные проекты используют очень прямой и информативный тон в своих заголовках, тогда как сайты более низкого качества содержат заголовки, которые вы привыкли видеть в объявлениях арбитражников (кликбейт, вроде: «12 продуктов, которые помогают при раке»).

И это исследователи всего лишь взглянули на заголовки. Кто знает, что можно извлечь из топов, проведя полноценный глубокий анализ. Интересное тут отметить, что один и тот же контент может, как приносить вам кучу обратных ссылок, заманивая кричащими заголовками и провокационными заявлениями, так и вредить, с точки зрения доверия поисковых систем, понижая вас в выдаче.

Профилирование конкурентов поможет вам подготовиться к ударам, которые последуют при следующих обновлениях основного алгоритма Google (а может, когда-то, и Яндекса; чем чёрт не шутит).

2. Сосредоточьтесь на основной теме вашего сайта

Один из ключевых моментов заявления Гугла состоит в том, что он смотрит, насколько качественно ваш сайт раскрывает конкретную тему. Обратимся ещё раз всё к той же цитате:

Другими словами, Гугл мыслит предметно. Алгоритм выходит за рамки отдельной веб-страницы, как таковой, и учитывает компетентность сайта по определённому предмету в целом. Учитывая, что мы с вами говорим о «профилировании», это имеет дополнительный смысл. Google не пытается угадать, является ли какая-то страница авторитетной. Он смотрит, стоит ли доверять всему сайту, когда дело доходит до данной темы.

Как следствие этого, было бы совершенно логично отточить конкретную тему, позволить Google насладиться вашим авторитетом в ней, а затем уже перейти к другим областям. Ведь дальше поисковик начнёт думать, что вы:

Это не значит, что я призываю стать экспертом в какой-то нише, а потом писать всякую кликбейтную ахинею, растрачивая кредит доверия поисковой системы. Думаю, Гугл довольно быстро заберёт назад этот кредит, при выкатывании очередного апдейта.

Скорее, я призываю публиковать контент в рамках определённого кластера, чтобы Гугл мог понять, что вы обладаете авторитетом в данной теме. Затем, полученный траст можно будет использовать для продвижения материалов смежных направлений.

Вместо того чтобы писать то про одно, то про другое, сконцентрируйтесь в начале на отдельном предмете изучения. Если хотите, соберите семантику по конкретной теме. Выпишите все запросы, которые собрали. Сгенерируйте статьи, опубликуйте, и уже после приступайте к следующему предмету.

Например, довольно тяжело будет сразу охватить все аспекты арбитража трафика, SMM или поисковой оптимизации сайтов. Начните с подтемы, вроде избранных сниппетов или монетизации мобильного Фейсбук-трафика через гемблинг-офферы. Создайте кучу контента, и когда убедитесь, что раскрыли подтему достаточно полно, переходите к следующей.

Март и апрель

В марте этого года западные вебмастера заметили изменения в позициях своих ресурсов. Это немедленно связали с возможным апдейтом – и не ошиблись. 12 марта сотрудник Google Дэнни Салливан проговорился об этом в Twitter:

«Каждый день Google запускает одно или несколько нововведений, призванных улучшить его показатели. Некоторые из нововведений узконаправленные. Некоторые – более широкого спектра. На прошлой неделе мы запустили апдейт основного алгоритма. Мы делаем это на регулярной основе несколько раз в год».

Позже, в апреле, Джон Мюллер пояснил, что это обновление было связано в первую очередь с релевантностью – в компании пытались определить соответствие тех или иных сайтов некоторым запросам. При этом Мюллер подчеркнул, что сайты, которые могли тогда пострадать и потерять в позиции, совсем не обязательно низкого качества, а чаще всего даже наоборот. Просто они перестали соответствовать «общей картине в сети».

В итоге SEO-сообщество пришло к выводу, это цель этого апдейта – показать, как оценивается релевантность контента и как Google корректирует свое понимание намерений пользователя (user intent). Это утверждение совпадает со словами представителей компании и результатами исследований, проведенных участниками рынка. Вот некоторые из них (на английском):

- Вывод Барри Шварца от 12 марта.

- Исследование Мари Хейнс от 23 апреля.

- Исследование Гленна Гейба от 16 мая.

- Исследование Гленна Гейба от 5 июня.

Важный аспект мартовского и апрельского апдейтов, на который мало кто обратил внимание – это то, что глубина и ширина контента сайтов стала учитываться в ранжировании. Так, ресурсы, максимально полно раскрывающие ту или иную тему, чувствовали себя во время раскатки обновлений лучше всех

Вот как Эндж определяет глубину и ширину контента:

- Создается экспертами в той или иной области.

- Публикуется большими объемами (десятки и сотни единиц контента в месяц).

- Раскрывает не только основную тему, но и релевантные «подтемы». Такая «ширина» может достигаться в том числе и публикацией нескольких статей, посвященных одному предмету.

- Контент, который не разбивается на отдельные публикации только ради увеличения количества статей на сайте. У каждого отдельного материала должна быть веская причина для публикации и демонстрации пользователям.

Многие сайты, отвечающие этим характеристикам, заметно улучшили свои позиции в марте и апреле. Вот показатели одного из таких ресурсов во время запуска весенних апдейтов:

Видимость сайта выросла почти вдвое. Это серьезный скачок. Такие результаты наблюдались для многих сайтов, публикующих контент, отвечающий вышеуказанным критериям.

Эндж привел пример того, как примерно должен выглядеть такой контент. К примеру, вы хотите, чтобы вас знали как хорошего специалиста по замене кухонных раковин. И вы вполне можете написать об этом большую статью, дополнив ее видео и прочими материалами. Для начала этого будет достаточно, но, возможно, вашей аудитории захочется получить информацию по одной из близких тем. Например:

- Утилизация старой раковины.

- Установка кухонной раковины.

- Как подвести водопроводные трубы к кухонной раковине.

- Какой герметик использовать.

- Сколько стоит заменить кухонную раковину.

- Какие инструменты необходимы для работы.

- Установка измельчителя мусора под раковиной.

- Сколько сантехник возьмет за установку?

- Смена водопроводного крана.

- Специфика латунных раковин.

- Особенности медных раковин.

Можно продолжать долго, но вы, скорее всего, уже поняли смысл.